实时同步数据,

增量的

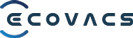

仅需几分钟,即可构建涵盖 60 多种数据源的端到端数据管道,轻松支撑实时分析与 AI 应用。无论您的数据位于云端还是本地,都能以低于 3 秒的超低延迟,实现极速、顺畅的数据流转。

0+客户数

0+下载和激活数

0+活跃的社区用户数

为什么选择 CloudCanal

百万行数据/月

了解更多Cost Comparison: BladePipe vs. Airbyte vs. Fivetran

1M 行/月

¥483

CloudCanal

(BYOC)

¥3240

Airbyte

(Cloud)

¥3600

Fivetran

(Standard)

10M 行/月

¥484

CloudCanal

(BYOC)

¥7200

Airbyte

(Cloud)

¥9720

Fivetran

(Standard)

100M 行/月

¥493

CloudCanal

(BYOC)

¥21600

Airbyte

(Cloud)

¥20880

Fivetran

(Standard)

1000M 行/月

¥583

CloudCanal

(BYOC)

¥100800

Airbyte

(Cloud)

¥86400

Fivetran

(Standard)

*: 包含一个阿里云 ECS t2.xlarge 工作节点,¥483/月

秒级同步

CloudCanal

<= 10 秒 *Airbyte

>= 1 分钟Fivetran

>= 1 分钟产品特性

CloudCanal 的关键特性

实时同步

低延迟,小于 3 秒,实时同步和更新,让数据更有价值,业务具有更多可能性。

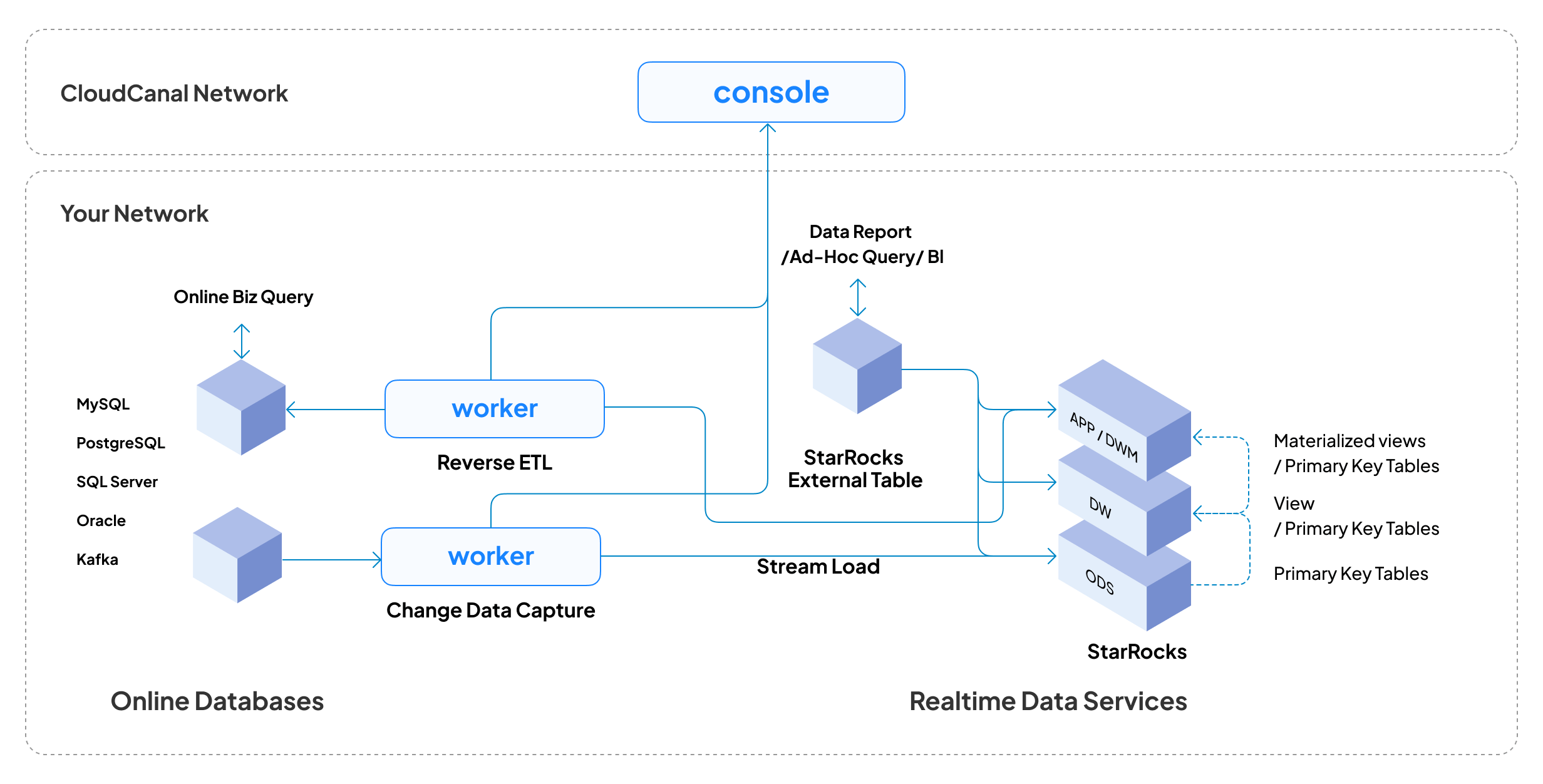

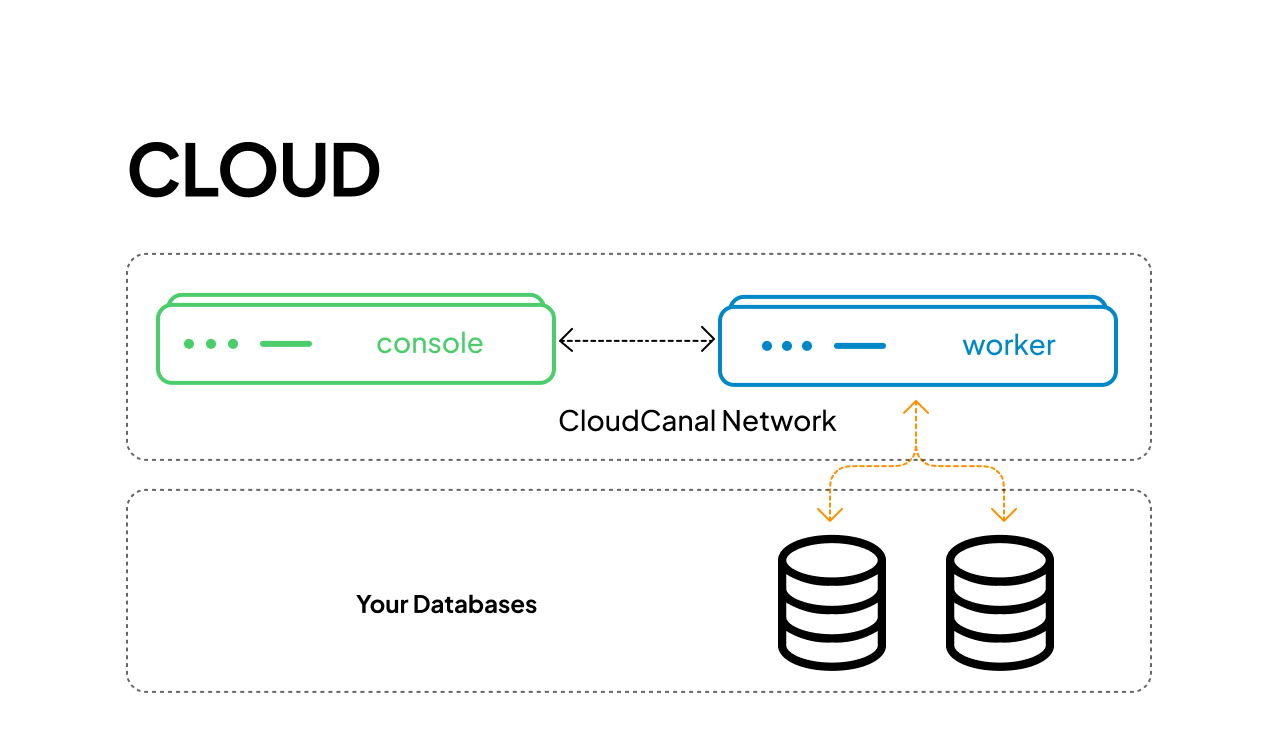

数据安全

数据不出用户网络,无需连接外网,避免数据泄露风险。

可视化,自动化

操作便捷,门槛更低。自动化的任��务流转减少了手动操作。

精准传输

数据高度一致,精准异构数据转化,并内置校验与订正功能。

端到端架构

结构简单,问题排查便利,低延迟,满足大部分场景。

60+ 数据源

支持主流数据库、实时仓库、消息队列、搜索引擎和缓存 — 更多数据源正在被支持中。

产品功能

丰富的功能,简单的操作

01

增量同步

全量迁移

结构迁移和同步

数据校验和订正

GenAI 服务

监控告警

增量同步

支持大部分数据链路,秒级别延迟

支持库表列等元数据映射

内置虚拟列、数据清洗、宽表构建、过滤条件等可视化能力

已经支持的数据源

更多的数据源正在被支持中

打通数据孤岛,丰富数据应用

解锁您的数据的巨大潜力。

了解更多

发现 CloudCanal 的巨大潜力

usecase

亿级数据迁移:某通信运营商子公司的跨云数据同步实践

某国内大型通信运营商子公司借助 CloudCanal 快速、平稳实现亿级数据跨云迁移与同步。

刘琳玉

Feb 6, 2026

usecase

某电商服务商如何在 5000 TPS 持续写入下实现实时数据同步

某电商运营服务商业务天然建立在高并发、强实时的数据之上,CloudCanal 的多项核心设计正符合高并发在线业务的需求,帮助该公司稳定、低延迟地同步数据,全程零故障、零丢失。

刘琳玉

Feb 3, 2026

usecase

CloudCanal 助力某头部医疗服务商,规模化构建医疗数据底座

某头部医疗数字化服务商利用 CloudCanal 实现实时数据同步,助力智慧医疗数据底座的建设。

刘琳玉

Dec 25, 2025

联系我们

扫码添加微信,获取技术支持